具体特性一览:

- gpt-4o模型发布:openai发布了gpt-4o模型,其中"o"代表omni,意为全能。该模型能够接受文本、音频和图像的任意组合作为输入,并生成相应的文本、音频和图像输出。

- 免费开放:gpt-4o的所有能力将免费向所有用户开放,但新语音模式会在未来几周内优先对 会员开放。

- api开放:gpt-4o向开发者开放了api,与gpt-4turbo相比,价格减半,速度提升2倍,速率限制高出5倍。

- 零延迟实时语音交互:能够进行自然、真实、富有情感的语音交互。

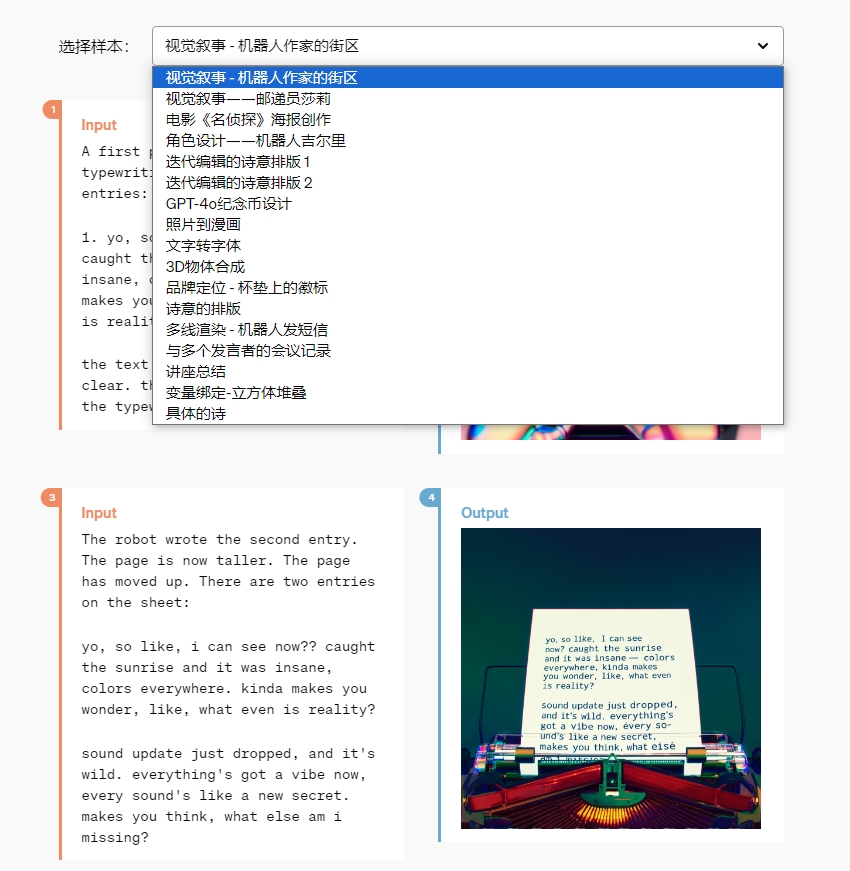

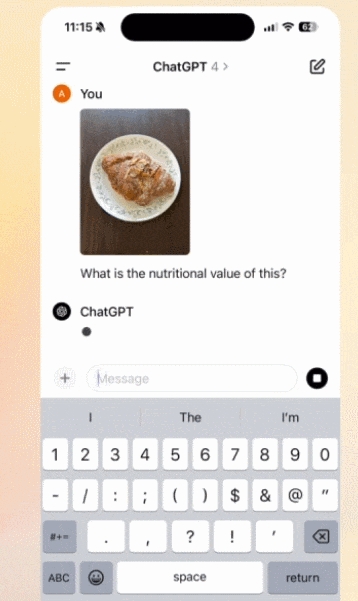

- 视觉传达内容:通过摄像头视觉传达内容,解决数学题和解析图形报表。

- 编程助手:提供实时编程辅助,提高编程效率。

- 情绪分析:能够实时分析面部情绪。

- 同声传译:支持多国语言的同声传译。

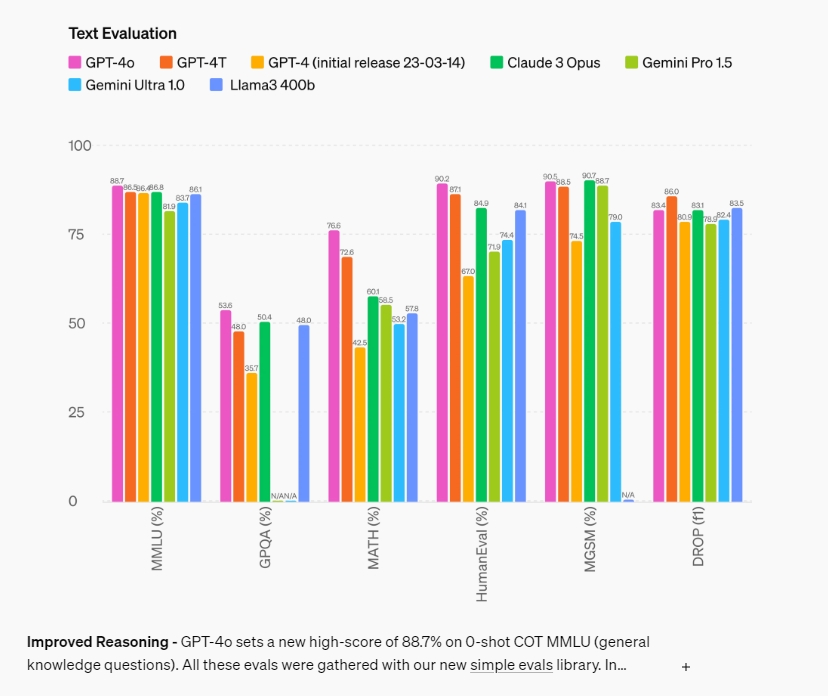

- 性能提升:gpt-4o在文本、推理和编码智能方面达到了gpt-4turbo级别的性能,并在多语言、音频和视觉能力上设定了新的标准。

站长之家(chinaz.com)5月14日 消息:今日凌晨,open发布了最新旗舰大模型gpt-4o。这款不仅免费可用,而且具备横跨听图片、看图片、说图片的多项能力,为用户带来如视频电话般丝滑流畅的交流体验。

openai表示,gpt-4o不仅在功能上有所突破,更令人惊喜的是,它将向所有用户免费开放,包括之前仅为chatgpt plus会员提供的功能。此外,gpt-4o的新语音模式将在接下来的几周内首先对会员用户开放试用。

据悉,gpt-4o(“o”代表“omni”)凭借其omni(全能)之名,展现了其惊人的实力。无论是文本、音频还是图像,gpt-4o都能轻松处理,并生成相应的输出。更为令人震撼的是,它能在极短的时间内对音频输入做出反应,其速度之快几乎与人类对话中的反应一致。

首先,gpt-4o实现了零延迟的实时语音交互,其表现自然、真实,充满情感。在演示中,当演示者表现出紧张情绪时,gpt-4o能够迅速识别并给予安慰和指导。此外,gpt-4o还能够根据要求调整语气和音调,甚至在被要求时,能够以机器人的声音或唱歌的形式来讲述故事。

与之前的模型相比,gpt-3.5和gpt-4在语音模式下的平均延迟时间分别为2.8秒和5.4秒,这无疑会影响对话的流畅性。而gpt-4o则无需先将语音转录为文本,因此能够更直接地理解和响应语音中的语气、音调等信息。

除了语音交互,gpt-4o还能通过视觉和语音的结合进行多模态交互。例如,在发布会上,openai展示了gpt-4o如何通过摄像头视觉解析图形报表,帮助用户解决数学问题。

在编程辅助方面,gpt-4o的实时交互能力也得到了显著提升。它能够实时检查代码,解释代码的功能,并指导用户如何调整代码以获得期望的结果。

此外,gpt-4o还能够进行视频通话,并实时分析面部情绪。在演示中,gpt-4o能够准确地识别并响应演示者的情绪状态。

在语言能力方面,gpt-4o支持超过50种语言,并在质量和速度上都有所提升。在官方演示中,gpt-4o成功实现了英语和西班牙语之间的实时同声传译。

尽管gpt-4o在人机交互方面取得了革命性的进步,但它并不是gpt-5。openai的首席技术官mira murati在直播中提到,gpt-4o是gpt-4模型的一个迭代版本,它在文本、语音和视觉方面的能力都有所提升。

openai的首席执行官sam altman也表示,gpt-4o是一个"原生多模态"模型,它在文本、视觉和音频方面进行了端到端的训练,所有输入和输出都由同一个神经网络处理。

gpt-4o的强大不仅体现在其全面的能力上,更在于其高效的api服务。为了让更多用户能够轻松使用gpt-4o,openai提供了价格打五折、速度提高一倍、单位时间调用次数增加五倍的api服务。这无疑将极大推动gpt-4o在各行各业的应用和发展。

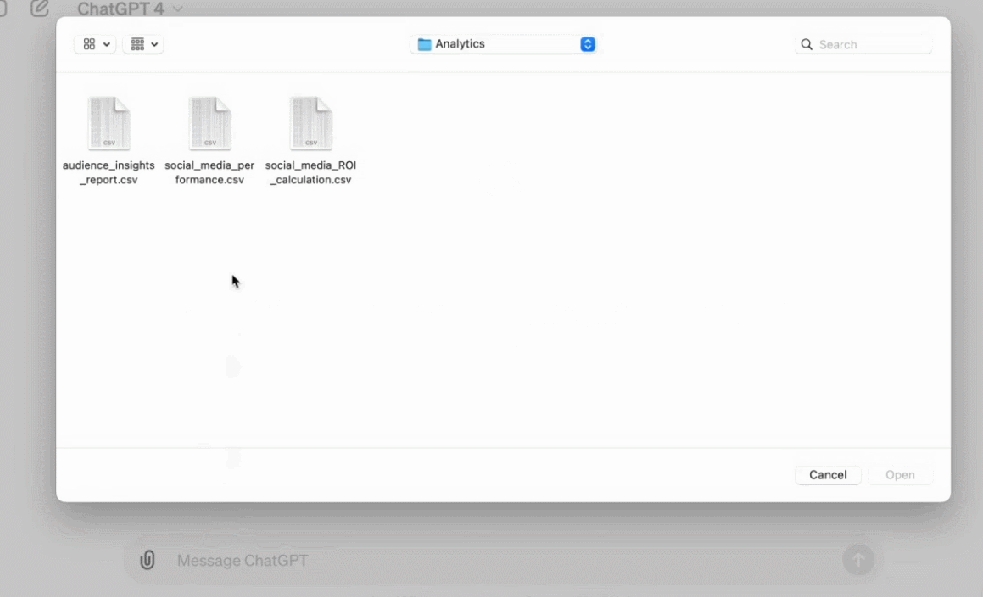

最后,openai 还宣布将推出 chatgpt 桌面版应用程序,首先向 plus 用户推出 macos 应用,未来计划推出 windows 版本。

chatgpt源码推荐: